Sipas një raporti të ri, kompanitë më të mëdha në botë që merren me Inteligjencën Artificiale (AI) nuk po përmbushin angazhimet e tyre për siguri, duke sjellë rreziqe “katastrofike”.

Raporti i indeksit të sigurisë së AI për vitin 2025, nxjerrë nga organizata jofitimprurëse Future of Life Institute (FLI), shqyrtoi tetë kompani kryesore, përfshirë Anthropic, OpenAI, dhe Google DeepMind nga SHBA, si dhe DeepSeek dhe Alibaba Cloud nga Kina.

Analizuesit e pavarur e vlerësuan se asnjë kompani nuk kishte paraqitur një plan të testueshëm për të ruajtur kontrollin njerëzor mbi sistemet e afta të AI-së.

Stuart Russell, një profesor i shkencave kompjuterike, shprehu shqetësimin se edhe pse këto kompani pretendojnë se mund të ndihmojnë në ndërtimin e AI-së supernjerëzore, ato nuk kanë treguar si do të parandalojnë humbjen e kontrollit.

Përsa i përket renditjes së kompanive, studimi vlerësoi gjashtë fusha kritike, përfshirë vlerësimin e riskut dhe kuadrin e sigurisë. Anthropic, OpenAI dhe Google DeepMind ishin lavdëruar për transparencën e tyre, por kryesisht kishin dobësi në aspekte të tjera.

P.sh., OpenAI u kritikua për standarde të paqarta të sigurisë dhe mungesë mbikëqyrjeje të pavarur.

Kompani të tjera si xAI dhe Z.ai patën progres të dukshëm, ndonëse ishin të kritikueshme për mungesën e detajeve në sistemin e sigurisë.

Meta ka prezantuar një kuadër të ri sigurie por kërkohet më shumë qartësi në proceset e vlerësimit brenda dhe jashtë saj.

Raporti gjithashtu evidentoi diskutimet e rritura mbi superinteligjencën dhe rrezikun që ajo përfaqëson për punësimin dhe përmbysjen shoqërore.

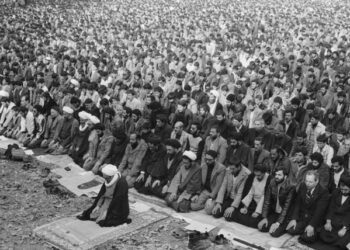

Të dhëna janë mbledhur nga një peticion i organizuar nga FLI, që kërkonte ngadalësimin e kësaj gare për superinteligjencën dhe që e nënshkruan figura të njohura nga politika, shkenca dhe feja.

Kjo situatë tregon një rritje të braktisjes ndaj kontrollit mbi AI-në, duke i bërë thirrje kompanive të krijojnë mekanizma më të forta për menaxhimin e këtyre teknologjive që ndodhen ende jashtë çdo rregullorje të fortë.